Źródło: Synteza technologii Sina

Użycie jednego aparatu do uzyskania nieostrej fotografii nie jest niczym nowym, poprzednieiPhone XRi wcześniejGoogle Pixel 2mieli podobne próby.

Nowy iPhone SE firmy Apple jest taki sam, ale jegoaparat fotograficznyelement jest za stary, główny kredyt nadal znajduje się w algorytmie.

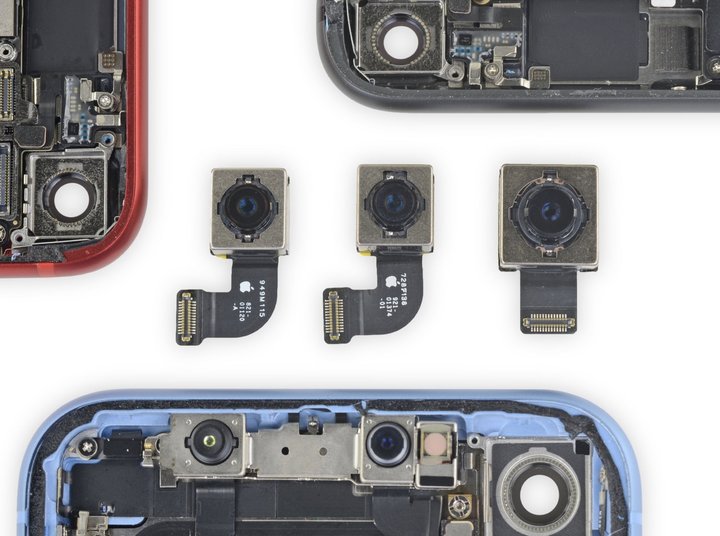

▲ Od lewej do prawej,aparat fotograficznyczujniki nowego iPhone'a SE,iPhone 8oraziPhone XR

Z raportu z demontażu iFixit widzimy, że niektóre części w nowym iPhone SE są całkowicie zgodne ziPhone 8, nawet do tego stopnia, że można ich używać zamiennie – w tym 12-megapikselowy szerokokątnyaparat fotograficzny .

Praktyka „nowego wina w starych butelkach” nie jest niczym niezwykłym w przypadku iPhone'a SE.Wracając do czterech lat temu, pierwsza generacja iPhone'a SE również zastosowała wygląd 5s i większość sprzętu, więc Apple może podać niższą cenę.

Teoretycznie podczas kopiowania tego samego sprzętu kamery,aparat fotograficznycechy tych dwóch nie powinny się zbytnio różnić.Na przykład,iPhone 8nie obsługuje robienia zdjęć o małej głębi ostrości z wyraźnym obiektem i rozmytym tłem, co często nazywamy „trybem portretowym”.

Ale kiedy spojrzysz na stronę wsparcia Apple, przekonasz się, że tryb portretowy nie jest obsługiwany przeziPhone 8jest obsługiwany przez nowy iPhone SE – nawet jeśli specyfikacje tylnych obiektywów są dokładnie takie same.

W normalnych warunkach robienie niewyraźnych zdjęć telefonem komórkowym często wymaga dwóch aparatów – podobnie jak ludzkie oczy, telefon komórkowy również musi uzyskać dwa obrazy pod różnymi kątami przez dwa obiektywy w różnych pozycjach, a następnie połączyć kąty widok Różnica polega na oszacowaniu głębi ostrości w celu uzyskania rozmycia tła i utrzymania wyraźnego obiektu.

Seria Plus na liście lub X, XS i 11 w ostatnich latach zasadniczo opierają się na systemach z wieloma kamerami, aby ukończyć fotografowanie z rozmyciem portretowym.

Jak więc rozwiązuje przedni pojedynczy aparat iPhone'a?Rdzeń znajduje się w podczerwonym projektorze z matrycą punktową w systemie Face ID, który może również uzyskać wystarczająco dokładne dane o głębokości, co jest odpowiednikiem „obiektywu pomocniczego”.

Z tego punktu widzenia iPhone SE potrafi robić zdjęcia w trybie portretowym jest bardzo szczególny: po pierwsze nie robi wielu ujęć, po drugie nie ma Face ID, w zasadzie nie ma możliwości wsparcia sprzętowego.

Najwyraźniej Apple wprowadził pewne zmiany, których nie widzimy na poziomie oprogramowania.

Niedawno Ben Sandofsky, twórca zewnętrznej aplikacji fotograficznej Halide, ujawnił zasady techniczne, wyjaśniając, dlaczego nowy iPhone SE wykorzystuje te same specyfikacje z jednym obiektywem, coiPhone 8, ale może osiągnąć tryb zdjęć portretowych, którego ten drugi nie może.

Powiedzieli, że nowy iPhone SE prawdopodobnie będzie „pierwszym iPhonem, który może generować efekt rozmycia portretowego przy użyciu tylko jednego obrazu 2D”.

Można powiedzieć, żeiPhone XRnie jest też rozmyciem jednokamerowym.Czy SE nie tylko to kopiuje?

Jednak sytuacja demontażowa dowiodła, żekameryiPhone'a SE iiPhone XRnie są spójne, co również prowadzi do różnic w technicznym wykonaniu tych dwóch.

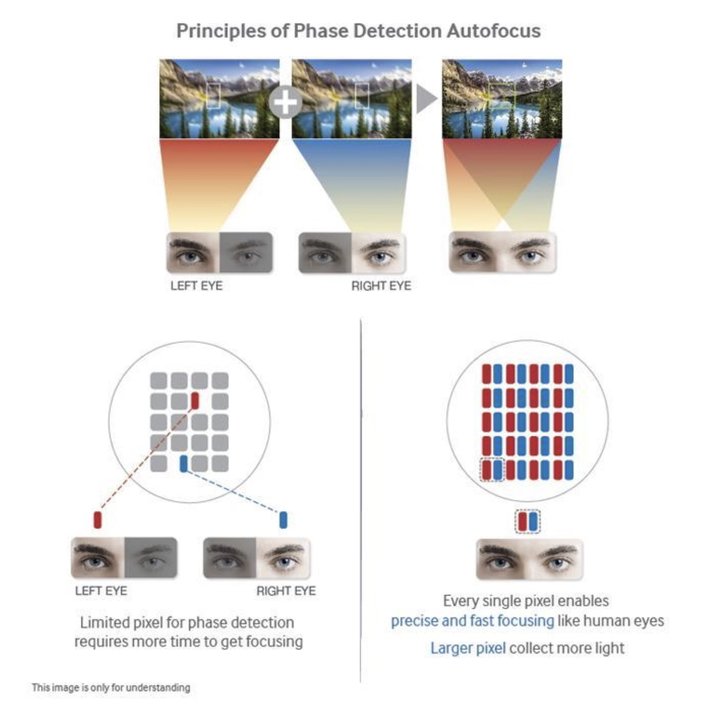

Samsung Galaxy S7seria to pierwsze urządzenie wykorzystujące technologię DPAF na smartfonieaparat fotograficzny

Najważniejsze jest to, żeaparat fotograficznyziPhone XRmoże korzystać z technologii autofokusa z dwoma pikselami (DPAF), która pozwala uzyskać określone dane dotyczące głębi w oparciu o sprzęt.

Mówiąc prościej, technologia DPAF jest odpowiednikiem dzielenia piksela naaparat fotograficznyczujnik na dwa mniejsze sąsiadujące ze sobą piksele, aby uchwycić dwa zdjęcia pod różnymi kątami, tak jak nasze lewe i prawe oko.

Chociaż różnica kątów wynikająca z tego nie jest tak oczywista jak w przypadku dualaparat fotograficzny, nadal sprzyja algorytmowi generowania danych o głębokości.

Google Pixel 2, 3Dwie mapy rozbieżności uzyskane przy użyciu technologii DPAF są trudne do odróżnienia gołym okiem

postrzegać, ale nadal może pomóc algorytmowi segmentacji obrazu w dokonywaniu osądów

Poprzednio,Googleużywał również tej technologii naPiksel 2, 3aby uzyskać rozmycie pojedynczego zdjęcia.NaPiksel4, ponieważ kamera została zastąpiona specyfikacją wielokamerową, detekcja paralaksy jest znacznie dokładniejsza niż w przypadku pojedynczej kamery.

▲ Przyjrzyjmy się danym uzyskanym przez Pixela 4 za pomocą dwóch kamer.

Jeśli chodzi o nowego iPhone'a SE, ponieważ jego czujniki są zbyt stare, Halide twierdzi, że nie może polegać na czujnikach w celu uzyskania map rozbieżności i zasadniczo może polegać tylko na algorytmie uczenia maszynowego dostarczonym przez chip A13 Bionic do symulacji i generowania danych o głębokości. mapy.

Jedno zdanie wyjaśnienia jest takie, że fotografowanie z rozmyciem portretowym iPhone'a SE jest w całości osiągane przez oprogramowanie i algorytmy.

▲ Zrób to zdjęcie bezpośrednio ziPhone XRi nowy iPhone SE

Halide użyłiPhone XRi nowy iPhone SE, aby zrobić zdjęcie szczeniaka (nie prawdziwe zdjęcie, tylko po to, aby zrobić zdjęcie „jednego zdjęcia”), a następnie porównać dane dotyczące głębokości dwóch zdjęć.

Odkryli, żeiPhone XRpo prostu wykonałem prostą segmentację obrazu, aby wyciągnąć główny korpus, ale nie rozpoznałem poprawnie ucha szczeniaka.

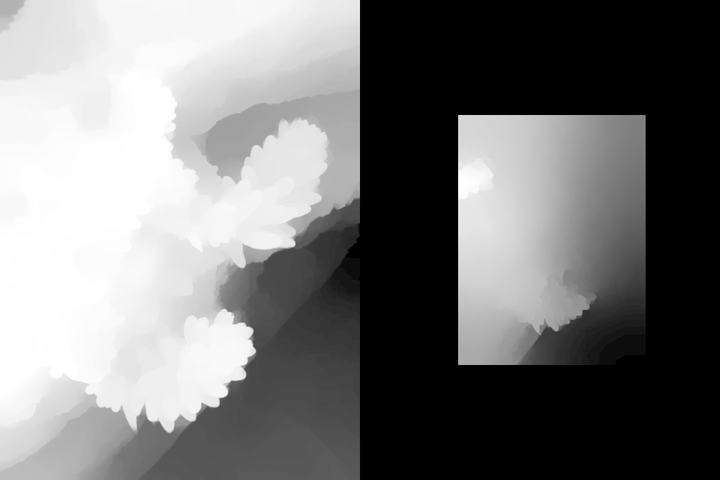

▲ Wykres danych głębokości,iPhone XRpo lewej nowy iPhone SE po prawej

Ale na nowym iPhonie SE, z nowym algorytmem dostarczonym przez chip A13, otrzymaliśmy mapę głębi, która jest zupełnie inna niżXR.Nie tylko poprawnie rozpoznaje uszy szczenięcia i ogólny zarys, ale także wykonuje warstwowe przetwarzanie dla różnych środowisk.

Ten rodzaj mapy głębi nie jest w 100% dokładny.Halide powiedział, że dokładność wycięcia i rozmycia nowego iPhone'a SE podczas robienia niewyraźnych zdjęć bez twarzy nie jest tak dokładna, jak podczas robienia portretów.

Zwłaszcza w przypadku, gdy niektóre obiekty i obrazy tła są bardzo rozmyte, przewaga wielu aparatów będzie teraz bardziej widoczna.

▲ W tego rodzaju motywie bez twarzy, a obiekt i tło nie są wyraźnie oddzielone, rozmycie nowego iPhone'a SE

łatwo popełniać błędy

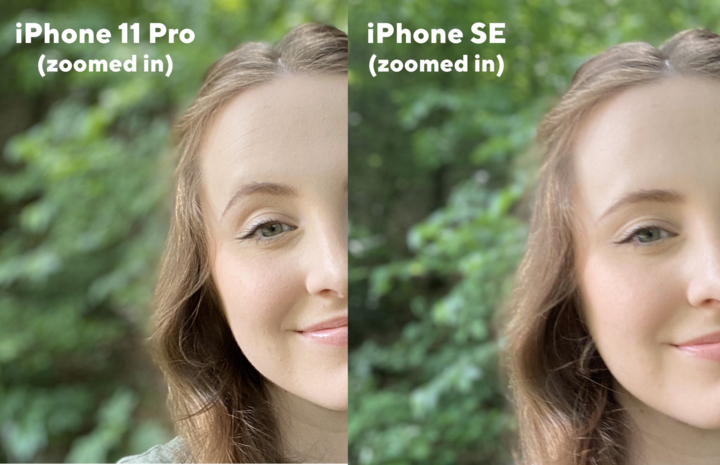

Jak widać na tym zdjęciu,iPhone 11 Prowyposażony w system wielokamerowy potrafi nie tylko całkowicie zarysować małe rośliny na kłodzie, ale także rozpoznać odległość od tła i dokonać warstwowej obróbki.

▲ Wykres danych głębokości,iPhone 11 Propo lewej nowy iPhone SE po prawej

W nowym iPhonie SE, pomimo tych samych wyników przetwarzania warstwowego, temat i tło zostały całkowicie połączone.Naturalnie proces post-rozmycia będzie naturalnie znacznie gorszy niżiPhone 11 Pro.

▲ Rzeczywiste zamazane dowody,iPhone 11 Propo lewej i nowy iPhone SE po prawej

Dlatego, gdy nowy iPhone SE korzysta z własnego systemu iOSaparat fotograficznytylko po wykryciu ludzkiej twarzy można włączyć „Tryb portretowy” w celu robienia nieostrych zdjęć.W innych przypadkach pojawi się błąd.

Powód jest nadal związany z algorytmem Apple.Halide wspomniał o technice zwanej „Portrait Effects Matte” (Portrait Effects Matte), która służy głównie do znajdowania dokładnych konturów osób na zdjęciach w trybie portretowym, w tym szczegółów, takich jak linia włosów na krawędzi, oprawka okularów itp. Obiekt i tło są podzielone na segmenty.

Ale obecnie ten zestaw technologii segmentacji opartej na uczeniu maszynowym jest bardziej przygotowany do „strzelania do ludzi”, może rzeczywiście zrekompensować brak danych paralaksy na pojedynczymaparat fotograficznytelefony takie jakiPhone XRi iPhone SE, ale jeśli temat Algorytm popełni błąd oceny podczas zmiany znaków z innych obiektów.

Jeśli chodzi o telefony z wieloma aparatami, takie jakiPhone 11 Pro, możesz uzyskać dane paralaksy bezpośrednio przezaparat fotograficznysprzęt, dzięki czemu mogą również używać trybu portretu w scenach bez twarzy, gdy używają własnychaparat fotograficzny.

▲ Przedni obiektyw nowego iPhone'a SE obsługuje również tryb portretowy, a precyzja twarzy jest bardzo wysoka,

a różnica w obrazowaniu dotyczy tylko efektu bokeh

Oczywiście deweloperzy zewnętrzni mogą nadal używać rzeczy, które nie są oficjalnie obsługiwane.Teraz aplikacja Halide może obsługiwaćiPhone XR, SE, aby robić niewyraźne zdjęcia małych zwierząt lub innych obiektów.W rzeczywistości wykorzystuje również technologię masek portretowych firmy Apple, aby uzyskać mapy głębi, a następnie dodać własną optymalizację zaplecza, aby to osiągnąć.

▲ Korzystając z aplikacji innych firm, takich jak Halide, możesz używać nowego iPhone'a SE do robienia niewyraźnych zdjęć osób, które nie mają twarzy

Ogólnie rzecz biorąc, rozmycie portretowe osiągnięte przez ten nowy iPhone SE to granica, którą można osiągnąć dzięki optymalizacji oprogramowania dla telefonów z jednym aparatem.Ściśle mówiąc, jest to spowodowane chipem A13.Jeśli nie przyniesie najnowszego algorytmu uczenia maszynowego,aparat fotograficznysamo doświadczenie, doświadczenie strzelania SE oczywiście musi być o połowę.

Dlatego też dla smartfonów wciąż ważne jest opracowywanie systemów wielokamerowych.Możemy użyć ultraszerokiego kąta, aby poszerzyć pole widzenia, i możemy polegać na teleobiekcie, aby uzyskać nieniszczące zdjęcia z zoomem.Pomoc w wykrywaniu w rozszerzonej rzeczywistości jest możliwa nie tylko dzięki uaktualnieniu OTA czy szlifowaniu algorytmów.

Oczywiście irytujące jest też ślepe przechwałki i rywalizacja o liczbę aparatów.Jeśli sprzęt określa tylko dolną granicę obrazowania, zestaw doskonałych algorytmów może znacznie podnieść górną granicę obrazowania, a nawet ponownie wyrazić wartość i wartość starego sprzętu.potencjał.

Nie wiem, czy możemy poczekać jeszcze cztery lata.Kiedy pojawi się kolejna generacja iPhone’a SE, będzie singielkamerzystanadal mieć miejsce w branży telefonii komórkowej?

Czas publikacji: 06.05-2020