出典:Sina Technology Synthesis

ぼやけた写真を実現するために単一のカメラを使用することは新しいことではありません。iPhone XRおよびそれ以前Google Pixel 2同様の試みがありました。

Appleの新しいiPhoneSEも同じですが、カメラ要素が古すぎます。主なクレジットはまだアルゴリズムにあります。

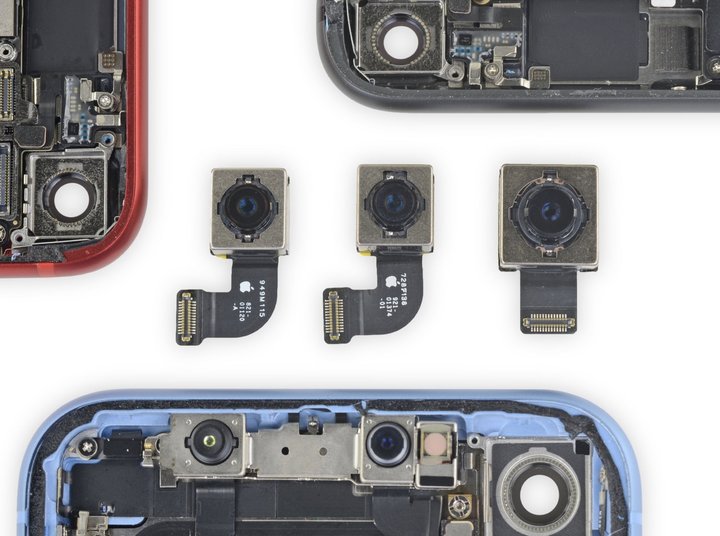

iFixitの分解レポートから、新しいiPhoneSEの一部の部品が完全に一貫していることがわかります。iPhone 8、互換的に使用できる範囲でさえ-12メガピクセルの広角を含むカメラ .

「古いボトルに入った新しいワイン」の習慣は、iPhoneSEにとって珍しいことではありません。4年前にさかのぼると、第1世代のiPhone SEも5sの外観とほとんどのハードウェアを適用していたため、Appleはより低価格を提供できます。

理論的には、同じカメラハードウェアをコピーする場合、カメラ2つの特性はそれほど変わらないはずです。例えば、iPhone 8被写体が鮮明で背景がぼやけている被写界深度の浅い写真の撮影はサポートされていません。これは、私たちがよく「ポートレートモード」と呼んでいるものです。

しかし、Appleのサポートページを見ると、サポートされていないポートレートモードがiPhone 82つのリアレンズの仕様がまったく同じであっても、新しいiPhoneSEでサポートされています。

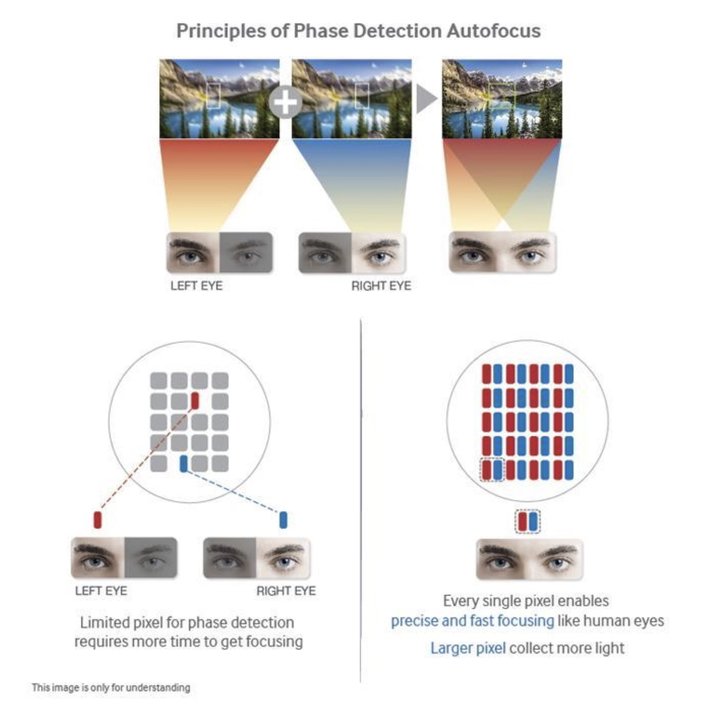

通常の状況では、携帯電話でぼやけた写真を撮るには、多くの場合、デュアルカメラで行う必要があります-人間の目と同じように、携帯電話も、異なる位置にある2つのレンズを介して異なる角度で2つの画像を取得し、ビュー違いは、背景のぼかしを実現し、被写体を鮮明に保つために被写界深度を推定します。

リストにあるPlusシリーズ、または近年のX、XS、および11は、基本的にマルチカメラシステムに依存してポートレートブラー撮影を完了します。

では、iPhoneのフロントシングルカメラはどのように解決するのでしょうか?コアはFaceIDシステムの赤外線ドットマトリックスプロジェクターにあり、「補助レンズ」に相当する十分に正確な深度データを取得することもできます。

この観点から、iPhone SEはポートレートモードの写真を撮ることができるのは非常に特別です。まず、複数のショットを撮らない、次に、Face IDがない、基本的にハードウェアサポートの可能性がありません。

どうやら、Appleはソフトウェアレベルでは見ることができないいくつかの変更を加えたようです。

最近、サードパーティのカメラアプリケーションHalideの開発者であるBen Sandofskyが技術原則を明らかにし、新しいiPhoneSEが同じシングルレンズ仕様を使用する理由を説明しました。iPhone 8、しかしそれは後者ができないポートレート写真モードを達成することができます。

彼らは、新しいiPhoneSEは「単一の2D画像のみを使用してポートレートブラー効果を生成できる最初のiPhone」になる可能性が高いと述べました。

あなたはそれを言うかもしれませんiPhone XRまた、シングルカメラのぼかしではありません。SEはそれをコピーするだけではありませんか?

▲サムスンギャラクシーS7シリーズは、スマートフォンでDPAFテクノロジーを使用する最初のデバイスですカメラ

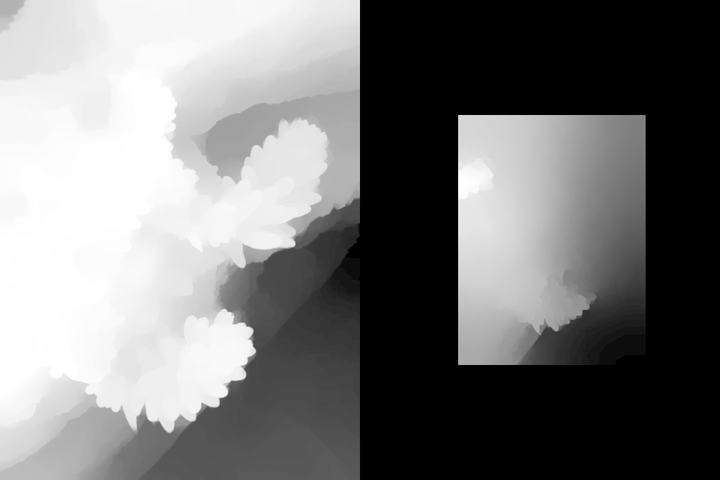

▲Google Pixel 2、3DPAFテクノロジーを使用して取得された2つの視差マップは、肉眼では困難です。

知覚しますが、それでも画像セグメンテーションアルゴリズムが判断を下すのに役立ちます

▲2台のカメラを使用してPixel4で取得したデータを見てみましょう。

新しいiPhoneSEについては、センサーが古すぎるため、Halideは、視差マップを取得するためにセンサーに依存することはできず、基本的にA13Bionicチップが提供する機械学習アルゴリズムにのみ依存して深度データをシミュレートおよび生成できると主張しています。マップ。

一文の説明は、iPhoneSEのポートレートブラー撮影はソフトウェアとアルゴリズムによって完全に達成されるということです。

▲この写真を直接撮るiPhone XRと新しいiPhoneSE

▲深度データグラフ、iPhone XR左側が新しいiPhoneSE、右側が新しいiPhone SE

しかし、新しいiPhone SEでは、A13チップによって提供される新しいアルゴリズムを使用して、完全に異なる深度マップを取得しました。XR。子犬の耳と全体的な輪郭を正しく認識するだけでなく、さまざまな背景のレイヤード処理も行います。

この種の深度マップは100%正確ではありません。ハライド氏によると、顔のないぼやけた写真を撮影するときの新しいiPhone SEの切り抜きとぼかしの精度は、ポートレートを撮るときほど正確ではないという。

特に被写体や背景画像が非常にぼやけている場合は、この時点で複数のカメラの利点がより明確になります。

▲このような顔以外のテーマでは、被写体と背景がはっきりと分離されていないため、新しいiPhoneSEのぼやけ

間違いやすい

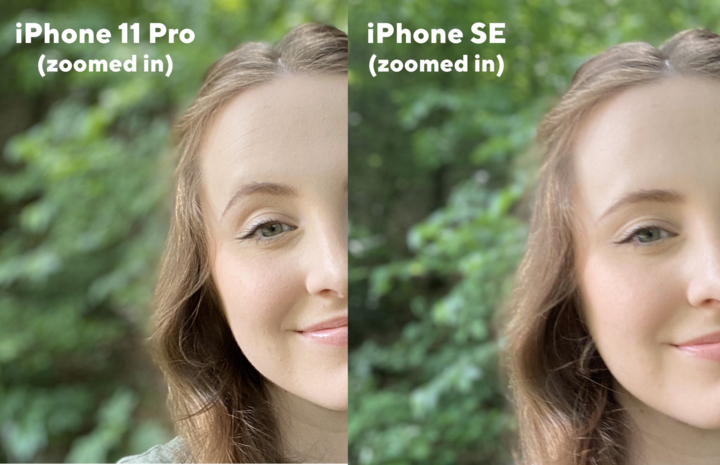

この写真からわかるように、iPhone 11 Proマルチカメラシステムを搭載することで、丸太の小さな植物の輪郭を完全に描くだけでなく、背景の距離を認識してレイヤード処理を行うことができます。

▲深度データグラフ、iPhone 11 Pro左側が新しいiPhoneSE、右側が新しいiPhone SE

新しいiPhoneSEでは、レイヤード処理の結果は同じですが、被写体と背景が完全に融合しています。当然のことながら、ぼかし後のプロセスは当然、iPhone 11 Pro.

▲実際のぼやけたプルーフ、iPhone 11 Pro左側が新しいiPhoneSE、右側が新しいiPhone SE

そのため、新しいiPhoneSEがiOS独自のものを使用する場合カメラアプリでは、人物の顔が検出された場合にのみ、「ポートレートモード」を有効にしてぼやけた写真を撮ることができます。それ以外の場合は、エラーが表示されます。

その理由はまだAppleのアルゴリズムに関連しています。ハライドは、「ポートレートエフェクトマット」(Portrait Effects Matte)と呼ばれる手法について言及しました。これは、主にポートレートモードの写真で、エッジのヘアラインやメガネのフレームなどの詳細を含む、人物の正確な輪郭を見つけるために使用されます。被写体と背景セグメント化されています。

しかし現在、機械学習に基づくこの一連のセグメンテーションテクノロジーは、「人を撃つ」ための準備が整っており、単一の視差データの不足を実際に補うことができます。カメラなどの電話iPhone XRおよびiPhoneSEですが、対象の場合、アルゴリズムは他のオブジェクトから文字を変更するときにも判断エラーを起こします。

のようなマルチカメラ付き携帯電話についてはiPhone 11 Pro、視差データを直接取得できます。カメラハードウェアなので、自分で使用する場合は、顔以外のシーンでもポートレートモードを使用できます。カメラ.

▲新しいiPhoneSEのフロントレンズはポートレートモードにも対応しており、顔の精度は非常に高く、

イメージングの違いはボケ効果だけです

もちろん、サードパーティの開発者は、公式にサポートされていないものを引き続き使用できます。これで、HalideアプリがサポートできるようになりましたiPhone XR、SEは、小動物やその他の物体のぼやけた写真を撮ります。実際、Appleのポートレートマスクテクノロジーを使用して深度マップを取得し、独自のバックエンド最適化を追加して実現しています。

▲Halideなどのサードパーティ製アプリを使用すると、新しいiPhone SEを使用して、顔以外の被写体のぼやけた写真を撮ることができます

一般に、この新しいiPhone SEによって達成されるポートレートブラーは、シングルカメラ付き携帯電話のソフトウェア最適化によって達成できる限界です。厳密に言えば、これは実際にはA13チップによるものです。最新の機械学習アルゴリズムが導入されていない場合は、カメラ単独での経験では、SE撮影の経験は明らかに半分でなければなりません。

したがって、スマートフォンがマルチカメラシステムを開発することは依然として意味があります。超広角で視野を広げ、望遠レンズで非破壊ズーム写真を撮ることができます。拡張現実検出のヘルプ。これらは、OTAのアップグレード、またはアルゴリズムの粉砕によってのみ達成されます。

もちろん、やみくもに自慢したり、カメラの数を競ったりするのも面倒です。ハードウェアがイメージングの下限のみを決定する場合、一連の優れたアルゴリズムはイメージングの上限を大幅に引き上げ、古いハードウェアの価値と価値を再表現することさえできます。潜在的な。

もう4年待つことができるかどうかわかりません。次世代のiPhoneSEが登場すると、シングルになりますカメラまだ携帯電話業界での地位を持っていますか?

投稿時間:2020年5月6日