Fuente: Sina Technology Synthesis

El uso de una sola cámara para lograr fotografías borrosas no es nada nuevo, lo anterioriPhone XRy antesGoogle Píxel 2han tenido intentos similares.

El nuevo iPhone SE de Apple también es el mismo, pero sucámaraelemento es demasiado antiguo, el crédito principal todavía está en el algoritmo.

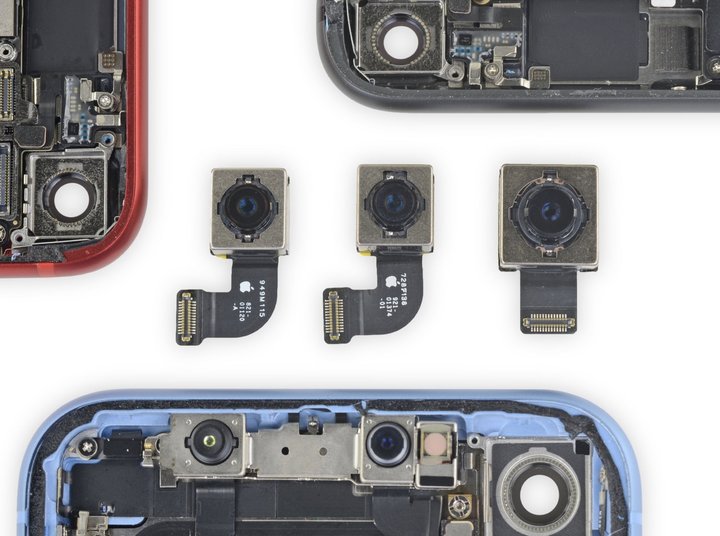

Del informe de desmontaje de iFixit, podemos ver que algunas partes del nuevo iPhone SE son completamente consistentes con eliPhone 8, incluso en la medida en que se pueden usar indistintamente, incluido el gran angular de 12 megapíxelescámara .

La práctica de 'vino nuevo en botellas viejas' no es inusual para el iPhone SE.Volviendo a hace cuatro años, el iPhone SE de primera generación también aplicó la apariencia de 5s y la mayor parte del hardware, por lo que Apple puede ofrecer un precio más bajo.

Teóricamente, al copiar el mismo hardware de cámara, elcámaralas características de los dos no deberían ser muy diferentes.Por ejemplo,iPhone 8no es compatible con la toma de fotografías con poca profundidad de campo con un sujeto claro y un fondo borroso, que es lo que a menudo llamamos "modo retrato".

Pero cuando mira la página de soporte de Apple, encontrará que el modo vertical que no es compatible con eliPhone 8es compatible con el nuevo iPhone SE, incluso si las especificaciones de la lente trasera de los dos son exactamente las mismas.

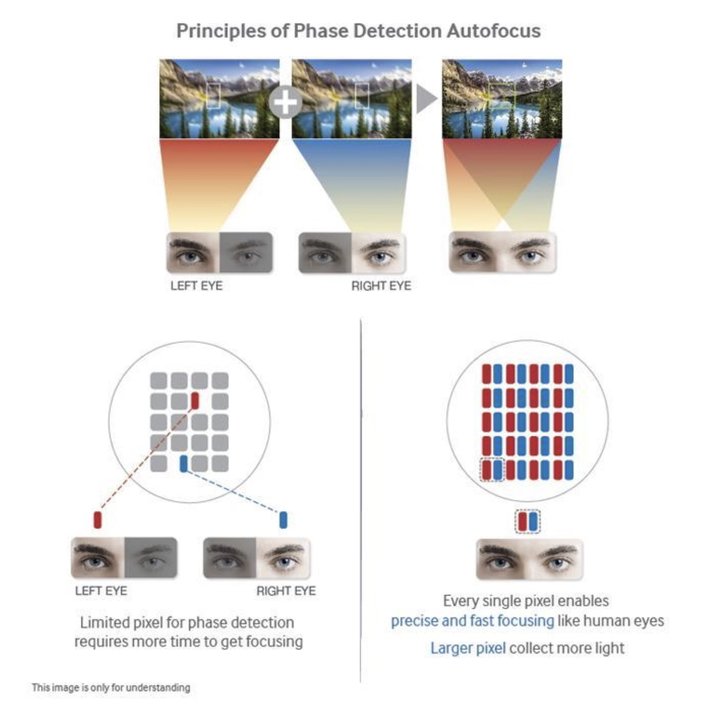

En circunstancias normales, la toma de fotos borrosas en un teléfono móvil a menudo debe realizarse con cámaras duales; al igual que los ojos humanos, el teléfono móvil también necesita obtener dos imágenes en diferentes ángulos a través de dos lentes en diferentes posiciones y luego combinar los ángulos de vista La diferencia estima la profundidad de campo para lograr un fondo borroso y mantener el sujeto claro.

La serie Plus de la lista, o la X, XS y 11 en los últimos años, básicamente se basan en sistemas multicámara para completar la toma de retratos borrosos.

Entonces, ¿cómo resuelve la cámara frontal única del iPhone?El núcleo reside en el proyector de matriz de puntos infrarrojos del sistema Face ID, que también puede obtener datos de profundidad suficientemente precisos, lo que equivale a una "lente auxiliar".

Desde este punto de vista, el iPhone SE puede tomar fotos en modo retrato es muy especial: primero, no toma múltiples tomas, segundo, no tiene Face ID, básicamente no hay posibilidad de soporte de hardware.

Al parecer, Apple ha realizado algunos cambios que no podemos ver a nivel de software.

Recientemente, Ben Sandofsky, el desarrollador de la aplicación de cámara de terceros Halide, reveló los principios técnicos y explicó por qué el nuevo iPhone SE usa las mismas especificaciones de lente única que eliPhone 8, pero puede lograr el modo de fotografía de retrato que este último no puede .

Dijeron que es probable que el nuevo iPhone SE sea "el primer iPhone que puede generar un efecto de desenfoque de retrato usando solo una imagen 2D".

Podrías decir que eliPhone XRtampoco es un desenfoque de una sola cámara.¿No está SE simplemente copiándolo?

Sin embargo, la situación del desmantelamiento ha demostrado que elcámarasdel iPhone SE yiPhone XRno son consistentes, lo que también conduce a diferencias en la implementación técnica de los dos.

▲samsung galaxia s7La serie es el primer dispositivo que utiliza la tecnología DPAF en un teléfono inteligentecámara

El punto más importante es que elcámaradeliPhone XRpuede usar la tecnología de enfoque automático de doble píxel (DPAF), que le permite obtener ciertos datos de profundidad basados en hardware.

En términos simples, la tecnología DPAF es equivalente a dividir el píxel en elcámarasensor en dos píxeles más pequeños uno al lado del otro para capturar dos fotos con diferentes ángulos, al igual que nuestros ojos izquierdo y derecho.

Aunque la diferencia de ángulo producida por esto no es tan obvia como la de doblecámara, todavía es propicio para que el algoritmo genere datos de profundidad.

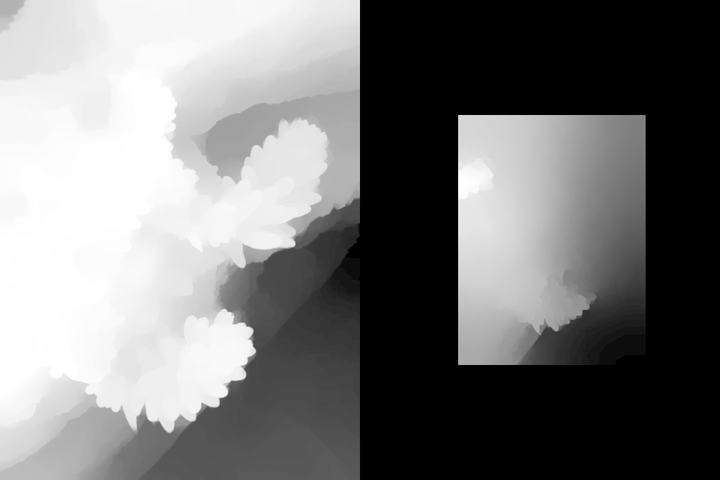

▲Google Píxel 2, 3Dos mapas de disparidad obtenidos con la tecnología DPAF son difíciles de identificar a simple vista.

percibir, pero aún puede ayudar al algoritmo de segmentación de imágenes a hacer juicios

Previamente,Googletambién usó esta tecnología enPíxel 2, 3para lograr el desenfoque de un solo disparo.Sobre elpíxel4, debido a que la cámara se reemplaza por una especificación de múltiples cámaras, la detección de paralaje es significativamente más precisa que una sola cámara.

▲ Echemos un vistazo a los datos obtenidos por el Pixel 4 usando dos cámaras.

En cuanto al nuevo iPhone SE, debido a que sus sensores son demasiado antiguos, Halide afirma que no puede confiar en los sensores para obtener mapas de disparidad y, básicamente, solo puede confiar en el algoritmo de aprendizaje automático proporcionado por el chip A13 Bionic para simular y generar datos de profundidad. mapas

La explicación de una oración es que el disparo de desenfoque de retrato del iPhone SE se logra completamente mediante software y algoritmos.

▲ Tome esta foto directamente coniPhone XRy nuevo iPhone SE

Haluro usó eliPhone XRy el nuevo iPhone SE para tomar una foto del cachorro (no una foto real, solo para tomar una foto de 'una foto'), y luego comparó los datos de profundidad de las dos fotos.

Descubrieron que eliPhone XRsimplemente hizo una segmentación de imagen simple para extraer el cuerpo principal, pero no reconoció correctamente la oreja del cachorro.

▲ Gráfico de datos de profundidad,iPhone XRa la izquierda, nuevo iPhone SE a la derecha

Pero en el nuevo iPhone SE, con el nuevo algoritmo proporcionado por el chip A13, obtuvimos un mapa de profundidad completamente diferente alXR.No solo reconoce correctamente las orejas del cachorro y el contorno general, sino que también realiza un procesamiento en capas para diferentes fondos.

Este tipo de mapa de profundidad no es 100% preciso.Halide dijo que la precisión del recorte y el desenfoque del nuevo iPhone SE cuando se toman fotos borrosas sin rostro no es tan precisa como cuando se toman retratos.

Especialmente en el caso de que algunos sujetos e imágenes de fondo estén muy borrosos, la ventaja de varias cámaras será más obvia en este momento.

▲ En este tipo de tema sin rostro, y el sujeto y el fondo no están claramente separados, el desenfoque del nuevo iPhone SE

es facil cometer errores

Como se puede ver en esta imagen, eliPhone 11 Proequipado con un sistema de múltiples cámaras, no solo puede delinear completamente las plantas pequeñas en el registro, sino que también puede reconocer la distancia del fondo y realizar un procesamiento en capas.

▲ Gráfico de datos de profundidad,iPhone 11 Proa la izquierda, nuevo iPhone SE a la derecha

En el nuevo iPhone SE, a pesar de los mismos resultados del procesamiento en capas, el sujeto y el fondo se han fusionado por completo.Naturalmente, el proceso posterior al desenfoque será mucho peor que eliPhone 11 Pro.

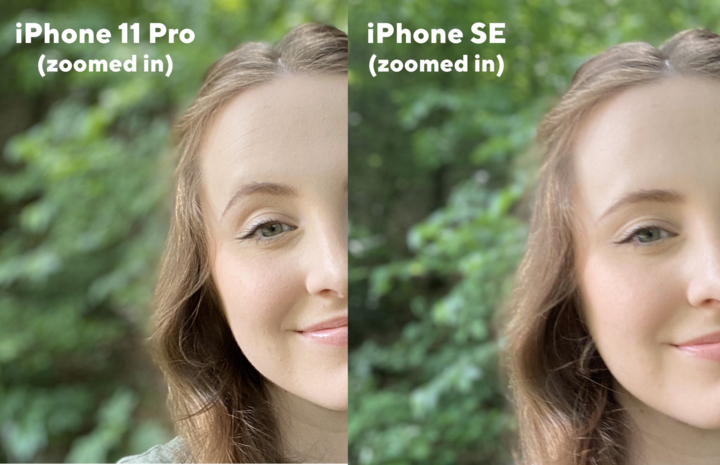

▲ Las pruebas borrosas reales,iPhone 11 Proa la izquierda y el nuevo iPhone SE a la derecha

Por eso, cuando el nuevo iPhone SE utiliza el propio iOScámaraaplicación, solo cuando se detecta un rostro humano, el "Modo de retrato" se puede habilitar para tomar fotos borrosas.En otros casos, aparecerá un error.

La razón todavía está relacionada con el algoritmo de Apple.Halide mencionó una técnica llamada 'Portrait Effects Matte' (Efectos de retrato mate), que se usa principalmente para encontrar el contorno preciso de las personas en fotos en modo retrato, incluidos detalles como la línea del cabello en el borde, el marco de las gafas, etc. El sujeto y el fondo están segmentados.

Pero en la actualidad, este conjunto de tecnología de segmentación basada en el aprendizaje automático está más preparado para "disparar personas", de hecho puede compensar la falta de datos de paralaje en un solocámarateléfonos comoiPhone XRy iPhone SE, pero si el sujeto El algoritmo también cometerá un error de juicio al cambiar caracteres de otros objetos.

En cuanto a teléfonos multicámara comoiPhone 11 Pro, puede obtener datos de paralaje directamente a través delcámarahardware, por lo que también pueden usar el modo de retrato en escenas sin rostro cuando usan su propiocámara.

▲ La lente frontal del nuevo iPhone SE también admite el modo retrato, y la precisión de la cara es muy alta,

y la diferencia de imagen está solo en el efecto bokeh

Por supuesto, los desarrolladores de terceros aún pueden usar cosas que no son compatibles oficialmente.Ahora la aplicación Halide puede admitiriPhone XR, SE para tomar fotografías borrosas de animales pequeños u otros objetos.De hecho, también utiliza la tecnología de máscara de retrato de Apple para obtener mapas de profundidad y luego agrega su propia optimización de back-end para lograrlo.

▲ Usando aplicaciones de terceros como Halide, puede usar el nuevo iPhone SE para tomar fotos borrosas de sujetos que no sean rostros

En general, el desenfoque de retrato que logra este nuevo iPhone SE es el límite que puede alcanzar la optimización de software para teléfonos con una sola cámara.Estrictamente hablando, esto se debe al chip A13.Si no trajera el último algoritmo de aprendizaje automático, elcámaraexperiencia sola, la experiencia de disparo SE obviamente tiene que ser la mitad.

Por lo tanto, sigue siendo significativo que los teléfonos inteligentes desarrollen sistemas multicámara.Podemos usar el ultra gran angular para ampliar el campo de visión, y podemos confiar en el teleobjetivo para obtener fotos con zoom no destructivo.Ayuda de detección de realidad aumentada, estos no solo se logran mediante una actualización de OTA o la molienda de algoritmos.

Por supuesto, fanfarronear ciegamente y competir por la cantidad de cámaras también es molesto.Si el hardware solo determina el límite inferior de la imagen, entonces un conjunto de algoritmos excelentes puede elevar significativamente el límite superior de la imagen e incluso volver a expresar el valor y el valor del hardware antiguo.potencial.

No sé si podemos esperar otros cuatro años.Cuando salga la próxima generación de iPhone SE, será sencillocámara¿Todavía tiene un lugar en la industria de la telefonía móvil?

Hora de publicación: 06-may-2020