Quelle: Sina Technology Synthesis

Die Verwendung einer einzigen Kamera, um unscharfe Fotografie zu erzielen, ist nichts Neues, die bisherigeiPhone XRund früherGoogle-Pixel 2ähnliche Versuche hatte.

Apples neues iPhone SE ist auch das gleiche, aber es istKameraelement zu alt ist, liegt das Hauptverdienst immer noch im Algorithmus.

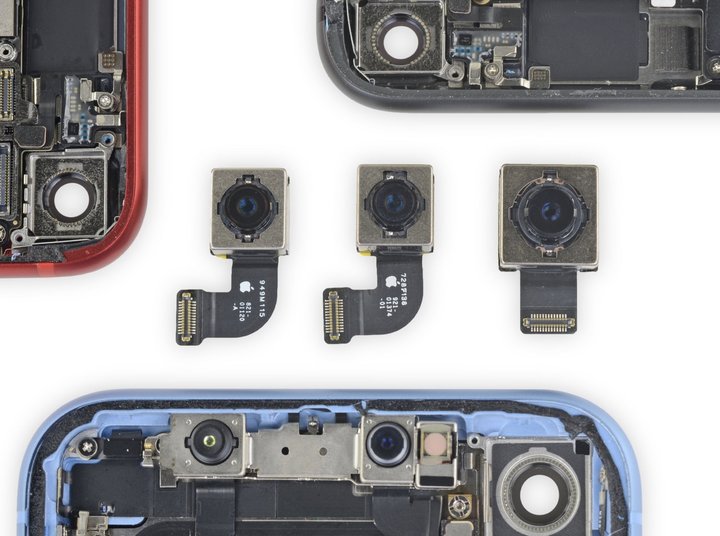

Aus dem Demontagebericht von iFixit können wir entnehmen, dass einige Teile im neuen iPhone SE vollständig mit dem übereinstimmeniPhone 8, sogar in dem Maße, in dem sie austauschbar verwendet werden können - einschließlich des 12-Megapixel-WeitwinkelsKamera .

Die Praxis „neuer Wein in alten Schläuchen“ ist für das iPhone SE nicht ungewöhnlich.Vor vier Jahren hat die erste Generation des iPhone SE auch das Aussehen von 5s und den größten Teil der Hardware übernommen, sodass Apple einen niedrigeren Preis anbieten kann.

Theoretisch wäre beim Kopieren der gleichen Kamerahardware dasKameraEigenschaften der beiden sollten nicht viel anders sein.Zum Beispiel,iPhone 8unterstützt nicht das Aufnehmen von Fotos mit geringer Schärfentiefe mit einem klaren Motiv und einem verschwommenen Hintergrund, was wir oft als "Porträtmodus" bezeichnen.

Aber wenn Sie sich die Support-Seite von Apple ansehen, werden Sie feststellen, dass der Hochformatmodus von der nicht unterstützt wirdiPhone 8wird vom neuen iPhone SE unterstützt, auch wenn die Spezifikationen der hinteren Linse der beiden genau gleich sind.

Unter normalen Umständen muss das Aufnehmen unscharfer Fotos auf einem Mobiltelefon oft mit zwei Kameras erfolgen – genau wie das menschliche Auge muss das Mobiltelefon auch zwei Bilder in unterschiedlichen Winkeln durch zwei Linsen an unterschiedlichen Positionen aufnehmen und dann die Winkel kombinieren Ansicht Die Differenz schätzt die Schärfentiefe, um eine Hintergrundunschärfe zu erzielen und das Motiv klar zu halten.

Die Plus-Serie auf der Liste oder die X, XS und 11 in den letzten Jahren verlassen sich im Wesentlichen auf Systeme mit mehreren Kameras, um unscharfe Porträtaufnahmen zu vervollständigen.

Wie löst also die vordere Einzelkamera des iPhones?Kernstück ist der Infrarot-Punktmatrixprojektor im Face-ID-System, der auch ausreichend genaue Tiefendaten gewinnen kann, was einer „Vorsatzoptik“ gleichkommt.

Aus dieser Sicht kann das iPhone SE Portrait-Modus-Fotos machen ist etwas ganz Besonderes: Erstens macht es keine Mehrfachaufnahmen, zweitens hat es keine Face ID, es gibt grundsätzlich keine Möglichkeit der Hardwareunterstützung.

Anscheinend hat Apple einige Änderungen vorgenommen, die wir auf Softwareebene nicht sehen können.

Kürzlich enthüllte Ben Sandofsky, der Entwickler der Drittanbieter-Kameraanwendung Halide, die technischen Prinzipien und erklärte, warum das neue iPhone SE die gleichen Einzelobjektiv-Spezifikationen verwendet wie dasiPhone 8, aber es kann den Porträtfotomodus erreichen, den letzteres nicht kann.

Sie sagten, dass das neue iPhone SE wahrscheinlich „das erste iPhone sein wird, das mit nur einem einzigen 2D-Bild einen Portrait-Unschärfe-Effekt erzeugen kann“.

Man könnte sagen, dass dieiPhone XRist auch keine Einzelkamera-Unschärfe.Kopiert n SE das nicht einfach?

Die Rückbausituation hat jedoch bewiesen, dass dieKamerasdes iPhone SE undiPhone XRsind nicht konsistent, was auch zu Unterschieden in der technischen Umsetzung der beiden führt.

▲Samsung Galaxy S7Serie ist das erste Gerät, das die DPAF-Technologie auf Smartphones verwendetKamera

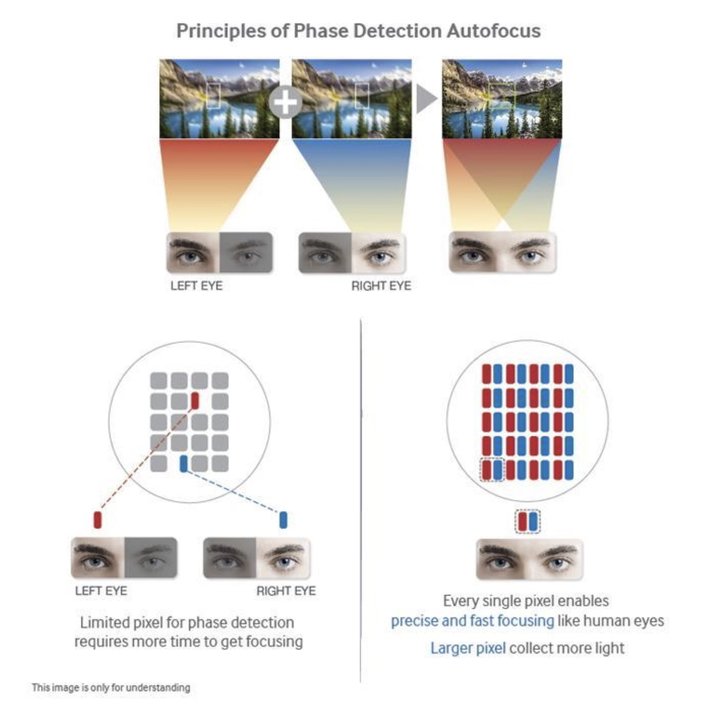

Der wichtigste Punkt ist, dass dieKameradesiPhone XRkann die Dual-Pixel-Autofokus-Technologie (DPAF) verwenden, die es ermöglicht, bestimmte Tiefendaten basierend auf der Hardware zu erhalten.

Einfach ausgedrückt entspricht die DPAF-Technologie der Aufteilung der Pixel auf derKameraSensor in zwei kleinere Pixel nebeneinander, um zwei Fotos mit unterschiedlichen Winkeln aufzunehmen, genau wie unser linkes und rechtes Auge.

Obwohl der dadurch erzeugte Winkelunterschied nicht so offensichtlich ist wie der von DualKamera, ist es für den Algorithmus immer noch förderlich, Tiefendaten zu generieren.

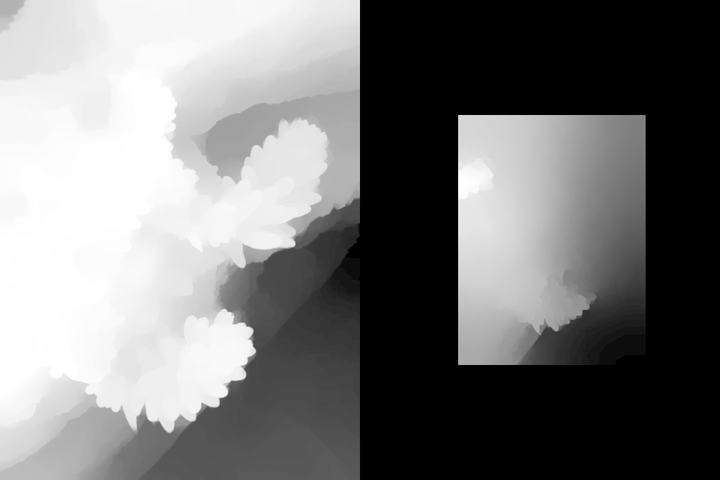

▲Google Pixel 2, 3Zwei Disparitätskarten, die mit der DPAF-Technologie erstellt wurden, sind mit bloßem Auge nur schwer zu erkennen

wahrnehmen, aber dennoch dem Bildsegmentierungsalgorithmus helfen können, Urteile zu fällen

Bisher,Googlenutzte diese Technik auch weiterPixel 2, 3um Einzelbildunschärfe zu erzielen.Auf derPixel4, da die Kamera durch eine Multi-Kamera-Spezifikation ersetzt wird, ist die Parallaxenerkennung deutlich genauer als bei einer Einzelkamera.

▲ Werfen wir einen Blick auf die Daten, die das Pixel 4 mit zwei Kameras gewonnen hat.

Da die Sensoren des neuen iPhone SE zu alt sind, behauptet Halide, dass es sich nicht auf die Sensoren verlassen kann, um Disparitätskarten zu erhalten, und sich im Grunde nur auf den maschinellen Lernalgorithmus verlassen kann, der vom A13 Bionic-Chip bereitgestellt wird, um Tiefendaten zu simulieren und zu generieren Karten.

Ein Satz erklärt, dass die Unschärfeaufnahme des iPhone SE-Porträts vollständig durch Software und Algorithmen erreicht wird.

▲ Nehmen Sie dieses Foto direkt mit aufiPhone XRund neues iPhone SE

Halogenid verwendet dieiPhone XRund dem neuen iPhone SE, um ein Foto des Welpen zu machen (keine echte Aufnahme, nur um ein Foto von „einem Foto“ zu machen), und dann die Tiefendaten der beiden Bilder verglichen.

Sie fanden heraus, dass dieiPhone XRhat gerade eine einfache Bildsegmentierung durchgeführt, um den Hauptkörper herauszuziehen, aber das Ohr des Welpen nicht richtig erkannt.

▲ Tiefendatendiagramm,iPhone XRlinks, neues iPhone SE rechts

Aber auf dem neuen iPhone SE haben wir mit dem neuen Algorithmus des A13-Chips eine völlig andere Tiefenkarte erhaltenXR.Es erkennt nicht nur die Ohren und den Gesamtumriss des Welpen korrekt, sondern führt auch eine mehrschichtige Verarbeitung für verschiedene Hintergründe durch.

Diese Art von Tiefenkarte ist nicht 100% genau.Halide sagte, dass die Genauigkeit des Ausschnitts und der Unschärfe des neuen iPhone SE beim Aufnehmen von unscharfen Fotos ohne Gesicht nicht so genau ist wie beim Aufnehmen von Porträts.

Besonders wenn einige Motive und Hintergrundbilder sehr unscharf sind, wird der Vorteil mehrerer Kameras zu diesem Zeitpunkt deutlicher.

▲ In dieser Art von Non-Face-Thema und Motiv und Hintergrund sind nicht klar voneinander getrennt, die Unschärfe des neuen iPhone SE

ist leicht, Fehler zu machen

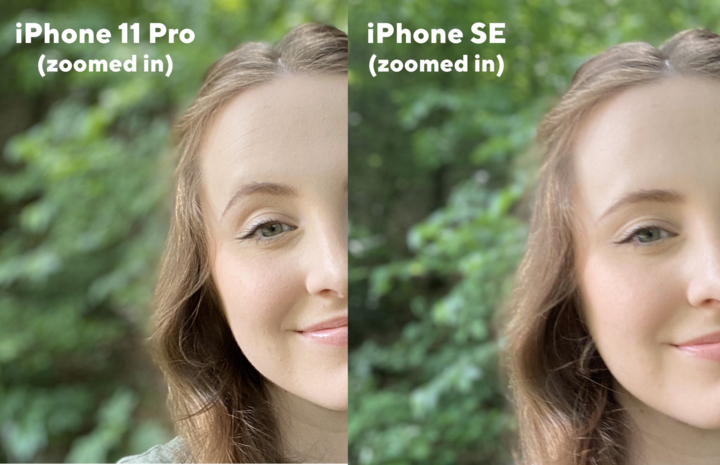

Wie Sie auf diesem Bild sehen können, ist dieiPhone 11 proAusgestattet mit einem Multikamerasystem kann er die kleinen Pflanzen auf dem Baumstamm nicht nur vollständig umreißen, sondern auch die Entfernung des Hintergrunds erkennen und schichtweise bearbeiten.

▲ Tiefendatendiagramm,iPhone 11 prolinks, neues iPhone SE rechts

Auf dem neuen iPhone SE wurden trotz der gleichen Ergebnisse der geschichteten Verarbeitung das Motiv und der Hintergrund vollständig miteinander verschmolzen.Natürlich wird der Post-Blurring-Prozess natürlich viel schlimmer sein als deriPhone 11 pro.

▲ Die tatsächlichen unscharfen Beweise,iPhone 11 prolinks und das neue iPhone SE rechts

Deshalb nutzt das neue iPhone SE das eigene iOSKameraapp, nur wenn ein menschliches Gesicht erkannt wird, kann der "Porträtmodus" aktiviert werden, um unscharfe Fotos aufzunehmen.In anderen Fällen wird ein Fehler angezeigt.

Der Grund hängt immer noch mit dem Algorithmus von Apple zusammen.Halide erwähnte eine Technik namens „Portrait Effects Matte“ (Portrait Effects Matte), die hauptsächlich verwendet wird, um die genauen Umrisse von Personen auf Fotos im Hochformat zu finden, einschließlich Details wie Haaransatz am Rand, Brillenrahmen usw. Motiv und Hintergrund sind segmentiert.

Aber derzeit ist diese auf maschinellem Lernen basierende Segmentierungstechnologie eher darauf vorbereitet, „Menschen zu erschießen“, sie kann tatsächlich den Mangel an Parallaxendaten auf Single ausgleichenKameraTelefone wie ziPhone XRund iPhone SE, aber wenn das Thema Der Algorithmus macht auch einen Beurteilungsfehler, wenn Zeichen von anderen Objekten geändert werden.

Wie für Handys mit mehreren Kameras wieiPhone 11 pro, können Sie Parallaxendaten direkt über die abrufenKameraHardware, sodass sie den Porträtmodus auch in Nicht-Gesichtsszenen verwenden können, wenn sie ihre eigene verwendenKamera.

▲ Die Frontlinse des neuen iPhone SE unterstützt auch den Porträtmodus, und die Präzision des Gesichts ist sehr hoch.

und der Abbildungsunterschied liegt nur im Bokeh-Effekt

Natürlich können Drittentwickler weiterhin Dinge verwenden, die nicht offiziell unterstützt werden.Jetzt kann die Halide-App unterstützeniPhone XR, SE, um verwackelte Bilder von kleinen Tieren oder anderen Objekten aufzunehmen.Tatsächlich verwendet es auch die Porträtmaskentechnologie von Apple, um Tiefenkarten zu erhalten, und fügt dann seine eigene Back-End-Optimierung hinzu, um dies zu erreichen.

▲ Mit Apps von Drittanbietern wie Halide können Sie mit dem neuen iPhone SE verschwommene Fotos von Motiven ohne Gesicht aufnehmen

Im Allgemeinen ist die von diesem neuen iPhone SE erreichte Porträtunschärfe die Grenze, die durch Softwareoptimierung für Telefone mit einer Kamera erreicht werden kann.Genau genommen liegt das tatsächlich am A13-Chip.Wenn es nicht den neuesten maschinellen Lernalgorithmus brachte, derKameraErfahrung allein, das SE-Schießerlebnis muss offensichtlich die Hälfte sein.

Daher ist es für Smartphones nach wie vor sinnvoll, Mehrkamerasysteme zu entwickeln.Wir können den Ultraweitwinkel verwenden, um das Sichtfeld zu erweitern, und wir können uns auf das Teleobjektiv verlassen, um zerstörungsfreie Zoomfotos zu erhalten.Augmented-Reality-Erkennungshilfe, diese werden nicht nur durch ein OTA-Upgrade oder das Schleifen von Algorithmen erreicht.

Natürlich ist es auch ärgerlich, blind anzugeben und um die Anzahl der Kameras zu konkurrieren.Wenn die Hardware nur die untere Grenze der Bildgebung bestimmt, dann kann eine Reihe hervorragender Algorithmen die obere Grenze der Bildgebung erheblich anheben und sogar den Wert und Wert alter Hardware wieder zum Ausdruck bringen.Potenzial.

Ich weiß nicht, ob wir noch vier Jahre warten können.Wenn die nächste Generation des iPhone SE herauskommt, wird SingleKameraa immer noch einen Platz in der Mobilfunkbranche?

Postzeit: 06. Mai 2020